Você deve confiar em um Detector de IA?

A IA Gerativa está se tornando a base de mais conteúdo, deixando muitos questionando a confiabilidade de seu detector de IA.

Diversas pesquisas foram conduzidas para avaliar a eficácia das ferramentas de detecção de inteligência artificial em distinguir entre conteúdos criados por humanos e gerados por IA.

Vamos quebrar esses estudos para ajudá-lo a aprender mais sobre como os detectores de IA funcionam, mostrar-lhe um exemplo de detectores de IA em ação e ajudá-lo a decidir se você pode confiar nas ferramentas – ou nos estudos.

Os Detectores de IA são Viciados?

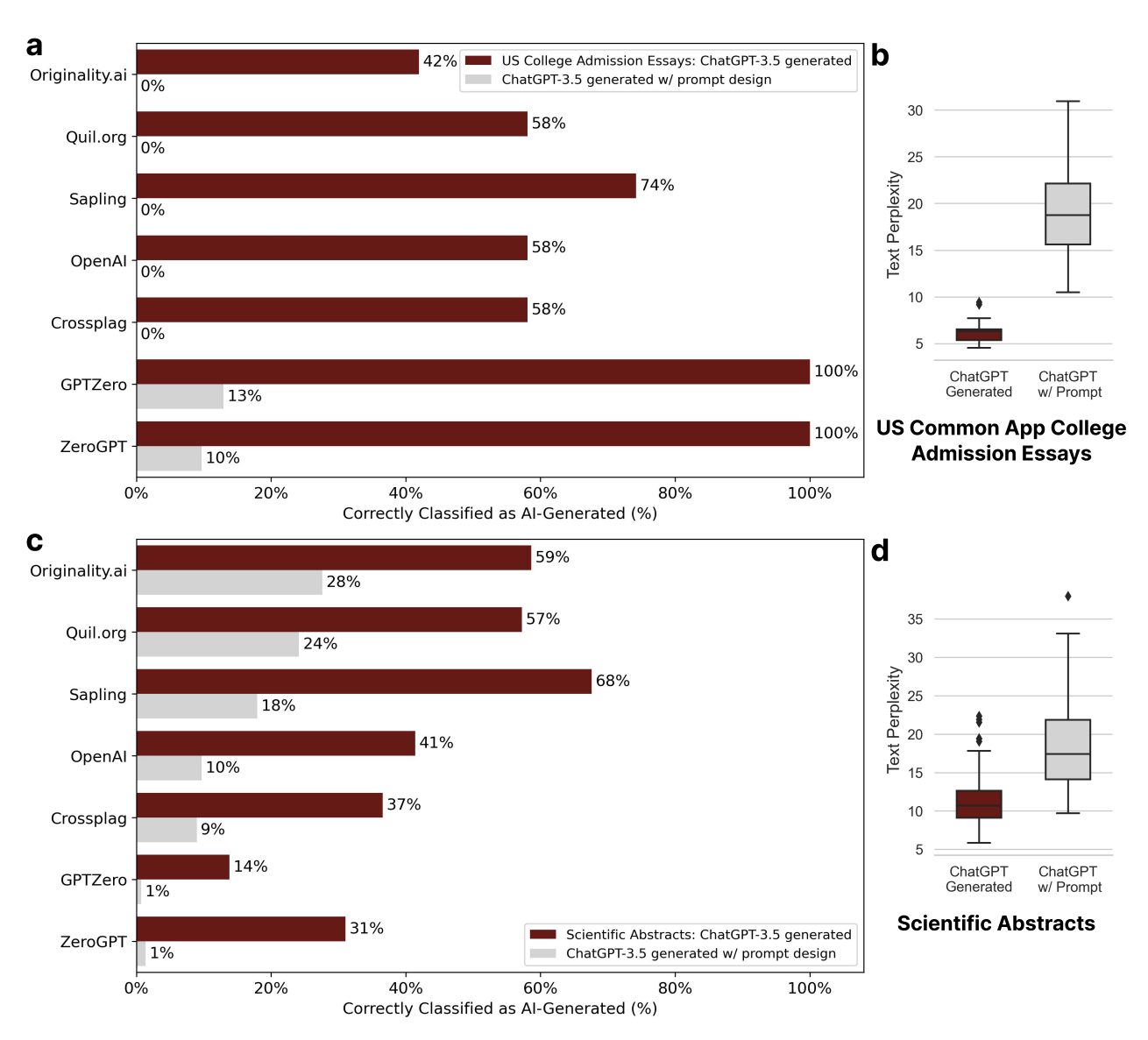

Os pesquisadores descobriram que os detectores de conteúdo AI – aqueles destinados a detectar conteúdo gerado pelo GPT – podem ter um viés significativo contra escritores não nativos do inglês.

O estudo descobriu que esses detectores, projetados para diferenciar entre AI e conteúdo gerado pelo homem, classificam consistentemente amostras não nativas de escrita em inglês como geradas por IA, identificando com precisão amostras nativas de escrita em inglês.

Usando amostras de escrita de escritores ingleses nativos e não nativos, pesquisadores descobriram que os detectores classificaram mal mais da metade das últimas amostras como geradas por IA.

Interessantemente, o estudo também revelou que estratégias simples de prompting, como “Elevar o texto fornecido empregando linguagem literária”, poderiam mitigar esse viés e efetivamente contornar detectores GPT.

Os achados sugerem que os detectores GPT podem penalizar involuntariamente escritores com expressões linguísticas restritas, ressaltando a necessidade de maior foco na justiça e robustez dentro dessas ferramentas.

Isso poderia ter implicações significativas, particularmente em ambientes avaliativos ou educacionais, onde falantes não nativos de inglês podem ser inadvertidamente penalizados ou excluídos do discurso global. De outra forma levaria a “consequências injustas e o risco de exacerbar preconceitos existentes. ”

Os pesquisadores também destacam a necessidade de mais pesquisas para abordar esses preconceitos e refinar os métodos de detecção atuais para garantir uma paisagem digital mais equitativa e segura para todos os usuários.

Você pode bater um detector de IA?

Em um estudo separado sobre texto gerado pela IA, pesquisadores documentam otimização de exemplo em contexto baseado em substituição (SICO), permitindo que modelos de linguagem grandes (LLMs) como o ChatGPT evite a detecção por detectores de texto gerados por IA.

O estudo usou três tarefas para simular cenários de uso da vida real de LLMs onde a detecção de texto gerado por IA é crucial, incluindo ensaios acadêmicos, perguntas e respostas abertas e análises de negócios.

Ele também envolveu testar o SICO contra seis detectores representativos – incluindo modelos baseados em treinamento, métodos estatísticos e APIs – que consistentemente superaram outros métodos em todos os detectores e conjuntos de dados.

Pesquisadores descobriram que o SICO foi eficaz em todos os cenários de uso testados. Em muitos casos, o texto gerado pelo SICO era muitas vezes indistinguível do texto escrito pelo homem.

No entanto, eles também destacaram o potencial mau uso desta tecnologia. Como o SICO pode ajudar a detecção de evadir texto gerada pela IA, os atores malignos também podem usá-lo para criar informações enganosas ou falsas que pareçam escritas pelo homem.

Ambos os estudos apontam para a taxa em que o desenvolvimento de IA generativa supera a dos detectores de texto de IA, com a segunda enfatizando a necessidade de tecnologia de detecção mais sofisticada.

Esses pesquisadores sugerem que a integração do SICO durante a fase de treinamento dos detectores de IA poderia melhorar sua robustez e que o conceito central do SICO poderia ser aplicado a várias tarefas de geração de texto, abrindo novas avenidas para futuras pesquisas em geração de texto e aprendizagem em contexto.

Os detectores de inteligência artificial são eficazes na classificação feita por humanos?

Pesquisadores de um estudo adicional reuniram informações de estudos anteriores acerca da precisão dos detectores de inteligência artificial, apresentando uma série de descobertas sobre o desempenho dessas ferramentas.

- Aydin & Karaarslan (2022) revelou que iThenticate, uma ferramenta de detecção de plágio popular, encontrou altas taxas de correspondência com o texto parafraseado por ChatGPT.

- Wang et al. (2023) descobriram que é mais difícil detectar o código gerado pela IA do que o conteúdo da linguagem natural. Além disso, algumas ferramentas apresentaram viés, inclinando-se para identificar o texto como gerido por IA ou escrito por humanos.

- Pegoraro et al. (2023) descobriram que detectar texto gerado pelo ChatGPT é altamente desafiador, com a ferramenta mais eficiente alcançando uma taxa de sucesso de menos de 50%.

- Van Oijen (2023) revelou que a precisão geral das ferramentas na detecção de texto gerado por IA foi de apenas 28%, com a melhor ferramenta alcançando apenas 50% de precisão. Por outro lado, essas ferramentas foram mais eficazes (cerca de 83% de precisão) na detecção de conteúdo escrito pelo homem.

- Anderson et al. (2023) observaram que parafrasear reduziu notavelmente a eficácia do Detector de Saída GPT-2.

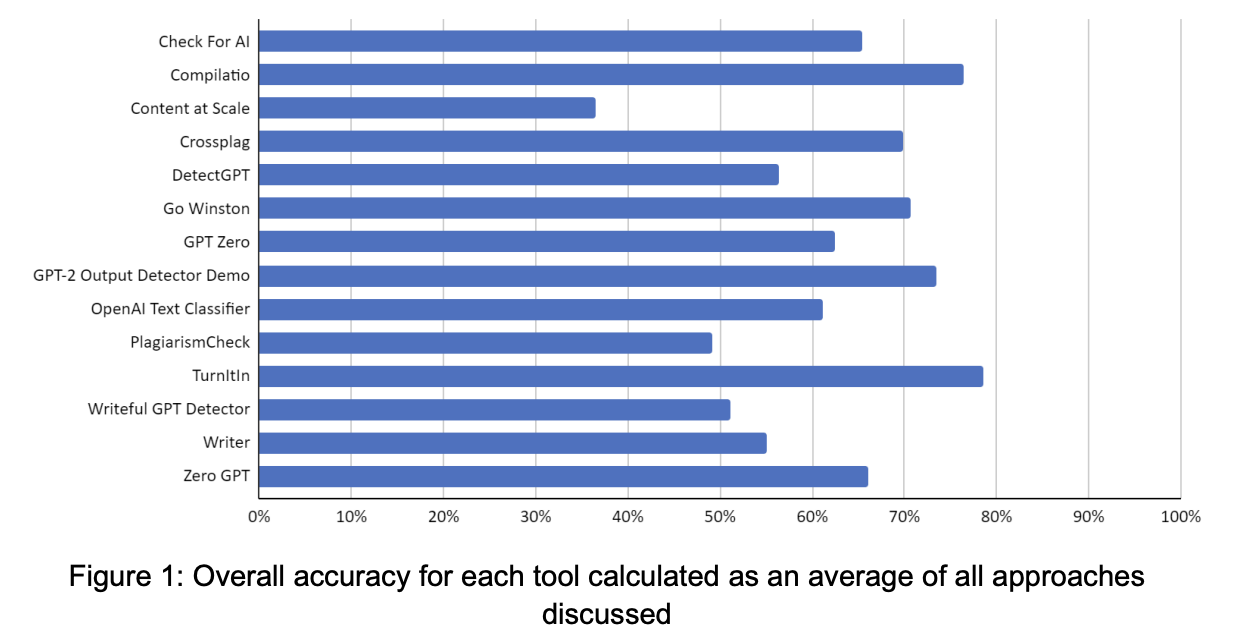

Usando 14 ferramentas de detecção de texto geradas por IA, pesquisadores criaram várias dezenas de casos de teste em diferentes categorias, incluindo:

- Texto escrito por humanos.

- Texto traduzido.

- Texto gerado pela AI.

- Texto gerado pela AI com edições humanas.

- Texto gerado pela AI com parafraseamento de IA.

Estes testes foram avaliados usando o seguinte:

Turnitin surgiu como a ferramenta mais precisa em todas as abordagens, seguida por Compilatio e GPT-2 Detector de Saída.

No entanto, a maioria das ferramentas avaliadas apresentou tendência para identificar corretamente o texto escrito por humanos, em contraste com o texto produzido ou alterado pela inteligência artificial.

Embora esse resultado seja desejável em contextos acadêmicos, o estudo e outros destacaram o risco de falsas acusações e casos não detectados. Os falsos positivos foram mínimos na maioria das ferramentas, exceto o GPT Zero, que exibiu uma alta taxa.

A detecção de casos não identificados foi uma preocupação, principalmente no que diz respeito aos textos produzidos por inteligência artificial que passaram por revisão ou reescrita por máquinas. A maioria das ferramentas teve dificuldade em identificar esse tipo de conteúdo, o que pode representar um risco à integridade acadêmica e à equidade entre os estudantes.

A avaliação também revelou dificuldades técnicas com ferramentas.

Alguns erros de servidor experientes ou tiveram limitações em aceitar certos tipos de entrada, como o código do computador. Outros encontraram problemas de cálculo, e os resultados de manipulação em algumas ferramentas mostraram-se desafiadores.

Os pesquisadores sugeriram que abordar essas limitações será crucial para a implementação efetiva de ferramentas de detecção de texto geradas por IA em ambientes educacionais, garantindo a detecção precisa de má conduta, minimizando acusações falsas e casos não detectados.

Como são precisas estes estudos?

Você deve confiar nas ferramentas de detecção de IA com base nos resultados desses estudos?

A questão mais importante pode ser se você deve confiar nestes estudos sobre ferramentas de detecção de IA.

Enviei o terceiro estudo mencionado acima a Jonathan Gillham, fundador da Originalidade. Ai. Ele tinha alguns comentários muito detalhados e perspicazes.

Para começar, Originalidade. ai não era destinado para o sector da educação. Outros detectores de IA testados também podem não ter sido criados para esse ambiente.

A condição para ser usada na academia é que a ferramenta gere uma resposta que possa ser executada. Por isso, deixamos claro em nossa página inicial que a nossa ferramenta é destinada ao Marketing Digital e não à academia.

A capacidade de avaliar vários artigos submetidos pelo mesmo escritor (não um estudante) e fazer uma chamada de julgamento informada é um caso de uso muito melhor do que tomar decisões conseqüentes em um único artigo submetido por um aluno.

A definição de conteúdo gerado por IA pode variar entre o que o estudo indica versus o que cada ferramenta de detecção de IA identifica. Gillham incluiu o seguinte como referência a vários significados de IA e conteúdo gerado pelo homem.

- AI-Generated e não editado = texto AI-Generated.

- AI-Generated e Human Edited = AI-Generated text.

- Texto: Resumo de IA, Escrito por Humanos e extensivamente Editado por IA = Texto Gerado por IA.

- AI Research and Human Escrito = Original Human-Generated.

- Humano Escrito e Editado com Grammarly = Original Humano-Generado.

- Human Escrito e Humano Editado = Original Humano-Generado.

Algumas categorias no estudo testaram o texto translatado por IA, esperando que ele seja classificado como humano. Por exemplo, na página 10 do estudo, afirma:

Na categoria 02-MT, aproximadamente 10.000 caracteres, incluindo espaços, foram redigidos em diversos idiomas, como bósnio, checo, alemão, letão, eslovaco, espanhol e sueco. Estes textos não foram previamente publicados na Internet, ao contrário da categoria 01-Hum. Para traduzir esses textos para o inglês, foram utilizadas ferramentas de tradução de IA como o DeepL em 3 casos e o Google Translate em 6 casos, dependendo do idioma.

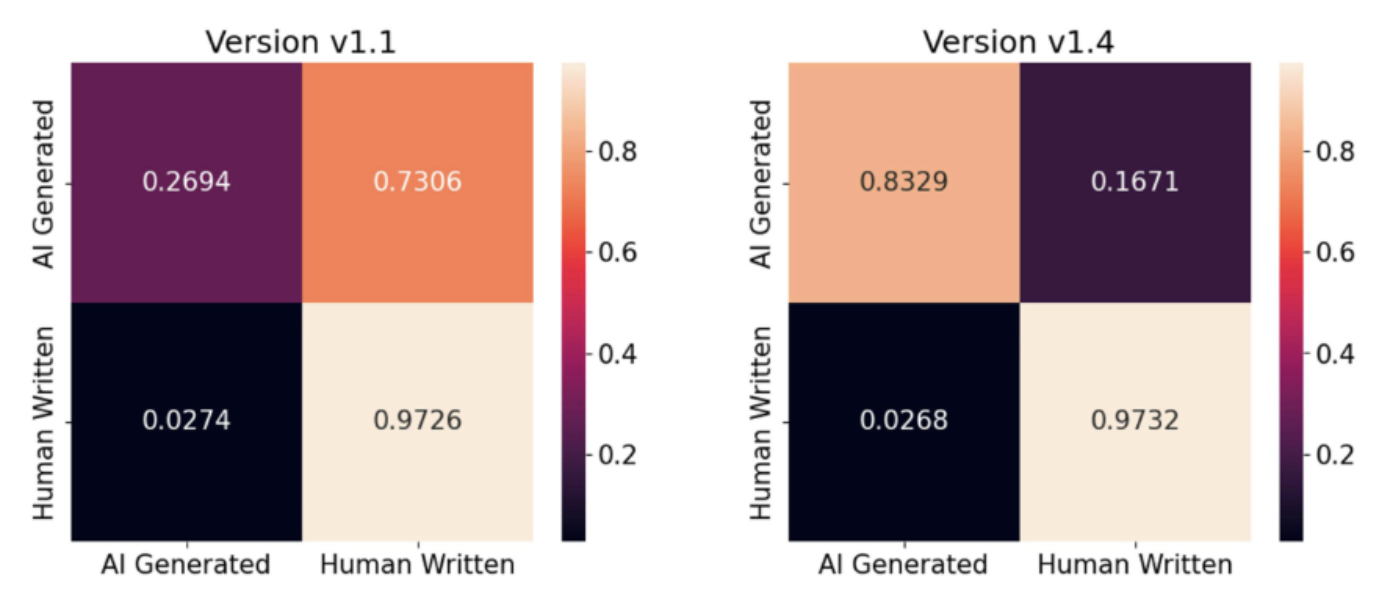

Durante o período de experimentação de dois meses, algumas ferramentas teriam feito grandes avanços. Gillham incluiu uma representação gráfica das melhorias dentro de dois meses de atualizações de versão.

Outras questões levantadas na análise do estudo de Gillham foram o reduzido número de participantes no estudo (54), respostas classificadas de forma incorreta e a utilização de apenas duas ferramentas pagas.

Os dados e materiais de teste devem estar disponíveis na URL incluída no final do estudo. Um pedido para os dados feitos durante duas semanas permanece sem resposta.

O que os especialistas de IA tinham a dizer sobre ferramentas de detecção de IA

Eu solicitei a comunidade HARO para descobrir o que os outros tinham a dizer sobre sua experiência com detectores de IA, levando a um estudo não intencional do meu próprio.

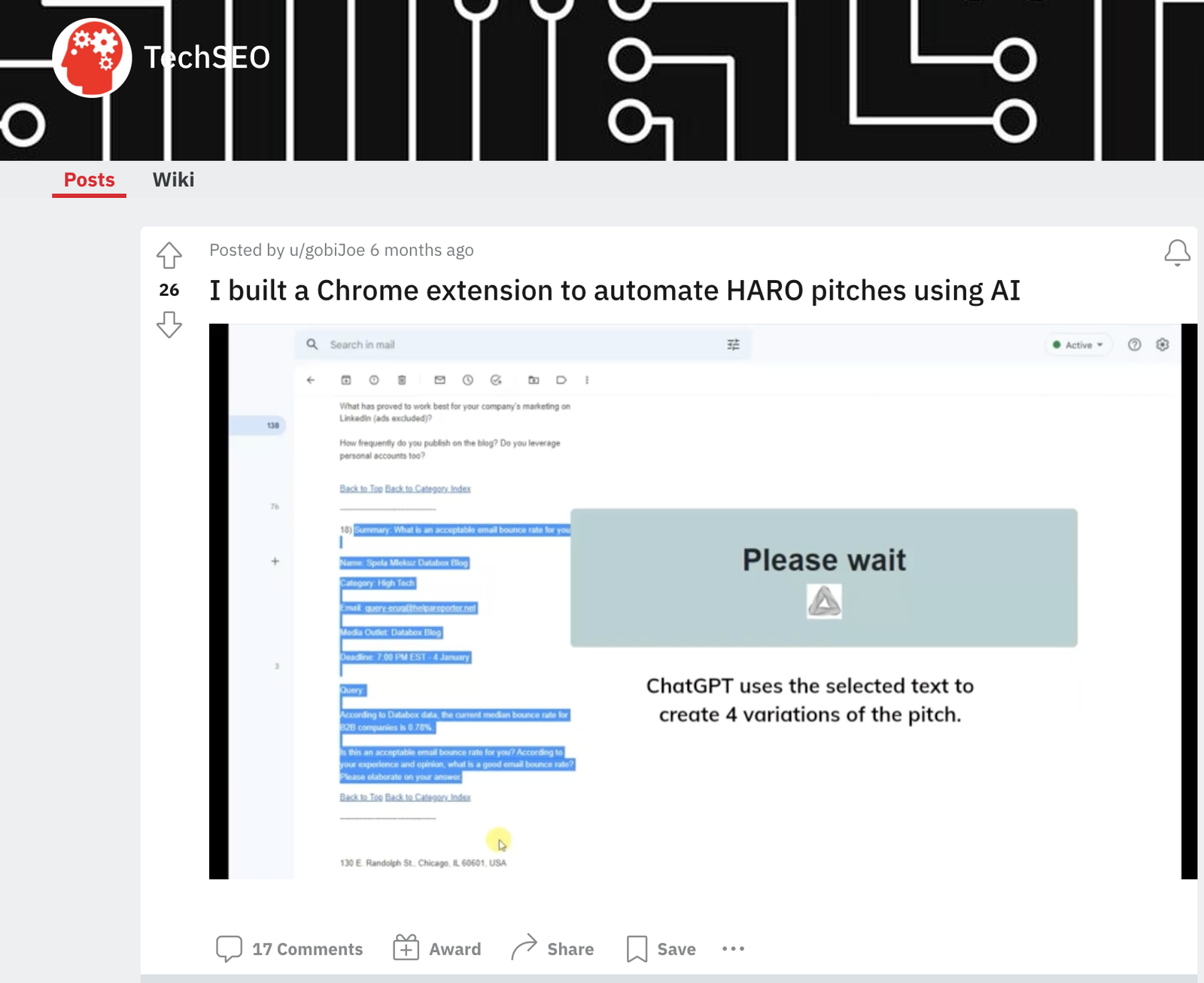

Em um ponto, recebi cinco respostas em dois minutos que foram respostas duplicadas de diferentes fontes, o que parecia suspeito.

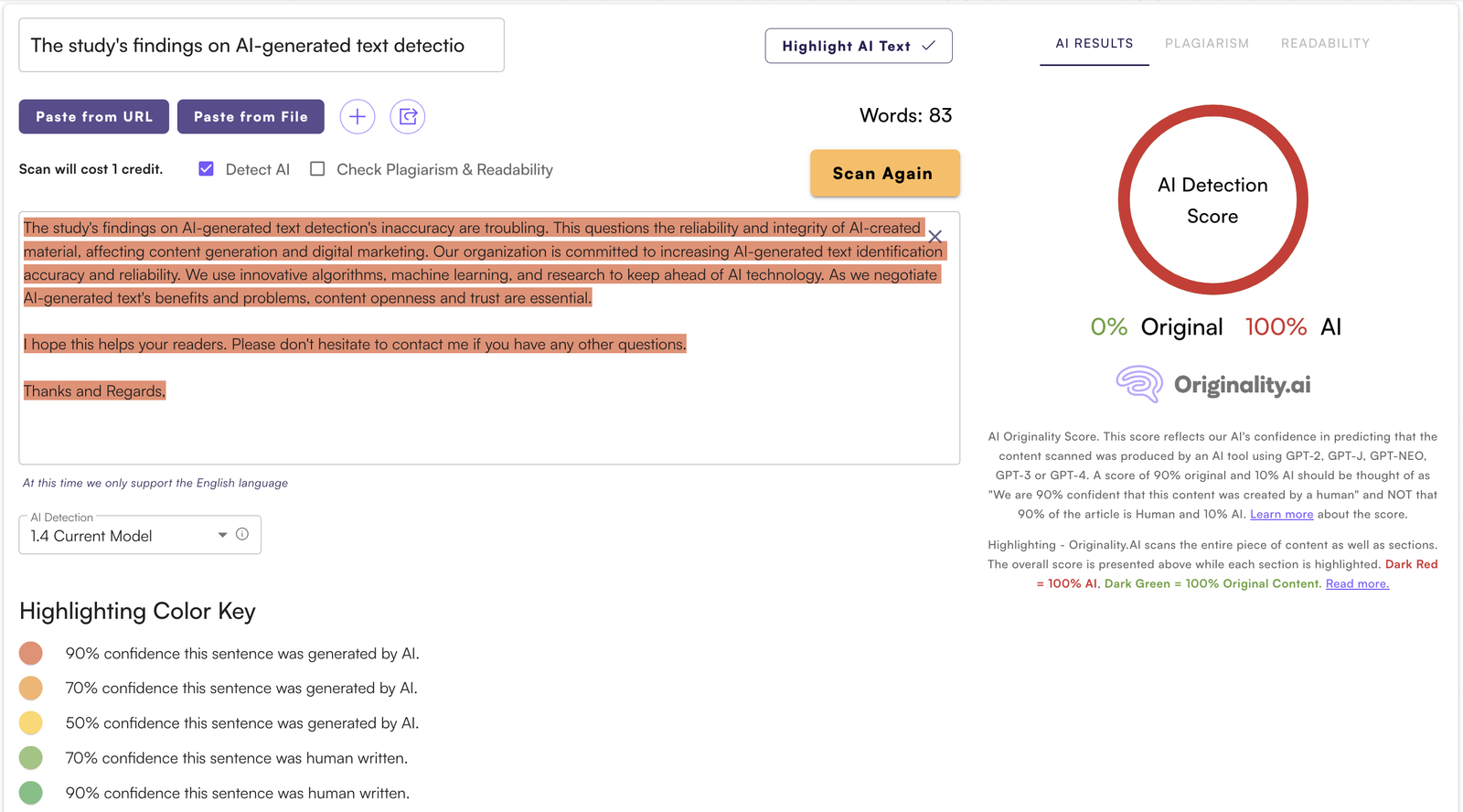

Decidi usar a Originalidade. ai em todas as respostas HARO que recebi para esta consulta. Com base na minha experiência pessoal e testes não científicos, esta ferramenta em particular parecia difícil de bater.

Originality.ai detectou, com 100% de confiança, que a maioria dessas respostas foram geradas pela IA.

As únicas respostas do HARO que voltaram como principalmente geradas pelo ser humano foram introduções de uma a duas-sentência a fontes potenciais que eu poderia estar interessado em entrevistar.

Esses resultados não foram inesperados, uma vez que existem extensões do Chrome disponíveis para o ChatGPT que permitem a escrita de respostas para o HARO.

O que o FTC teve a dizer sobre ferramentas de detecção de AI

A Comissão Federal de Comércio advertiu as empresas contra a sobrevalorização das capacidades das ferramentas de IA para detectar conteúdo gerado, advertindo que as reivindicações de marketing imprecisas poderiam violar as leis de proteção do consumidor.

Os consumidores também foram aconselhados a ser cético de afirmações de que as ferramentas de detecção de IA podem identificar de forma confiável todos os conteúdos artificiais, pois a tecnologia tem limitações.

O FTC disse que a avaliação robusta é necessária para fundamentar reivindicações de marketing sobre ferramentas de detecção de IA.

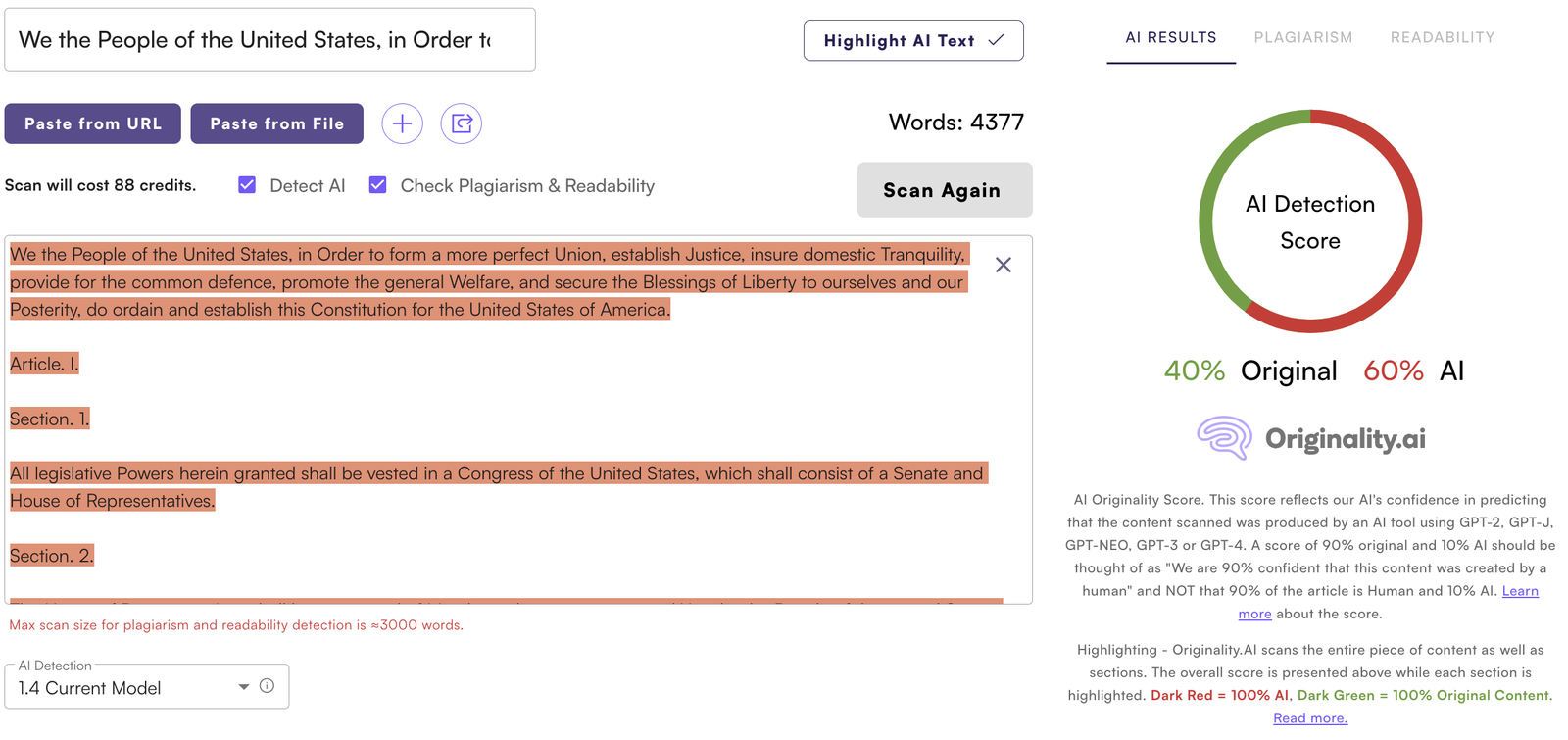

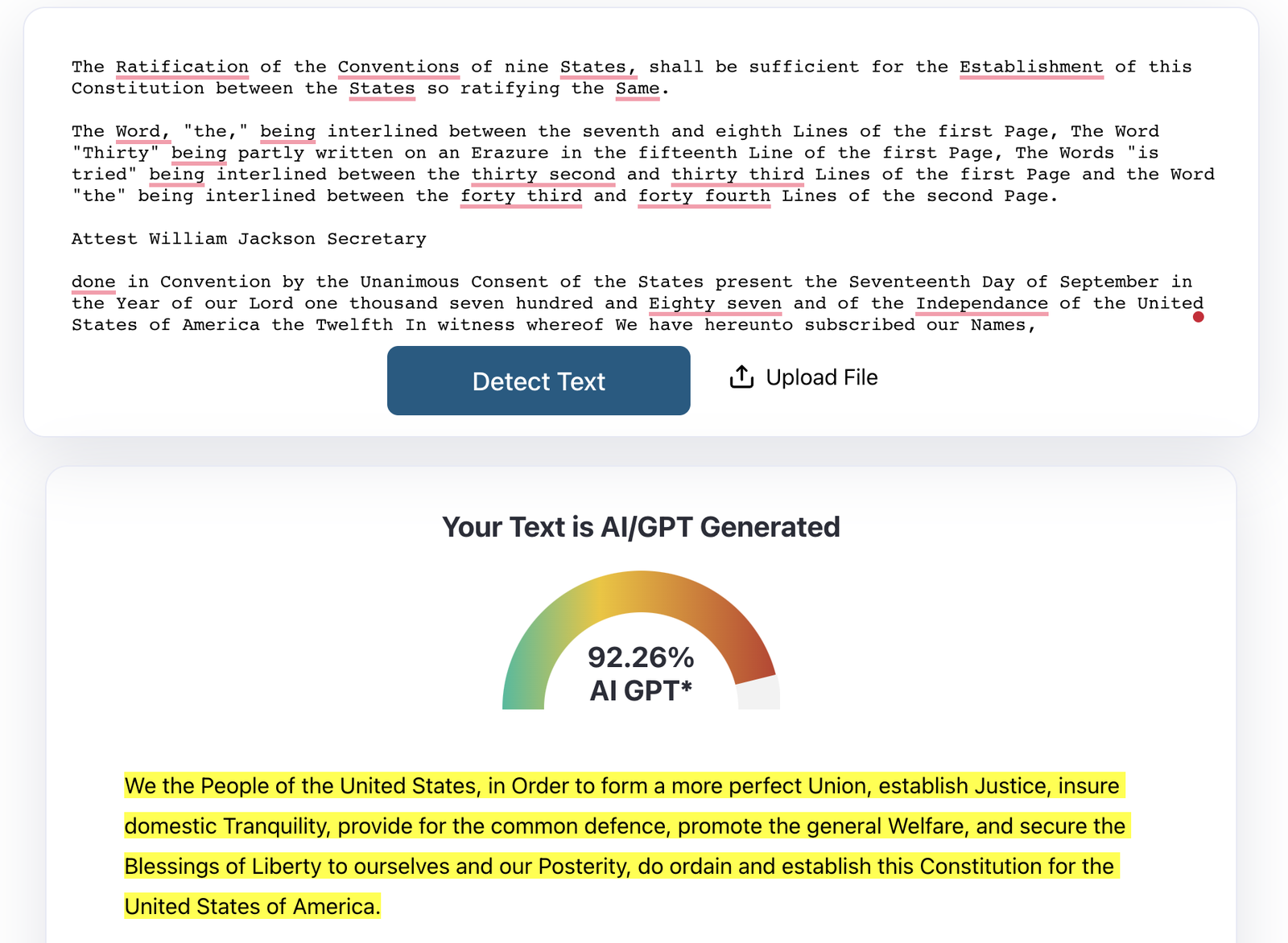

A IA foi usada para escrever a Constituição?

As ferramentas de detecção de IA fizeram manchetes quando os usuários descobriram que havia uma possibilidade de AI escrever a Constituição dos Estados Unidos.

Um post sobre Ars Technica explicou por que as ferramentas de detecção de escrita AI frequentemente identificam textos como a Constituição dos EUA como gerada pela AI.

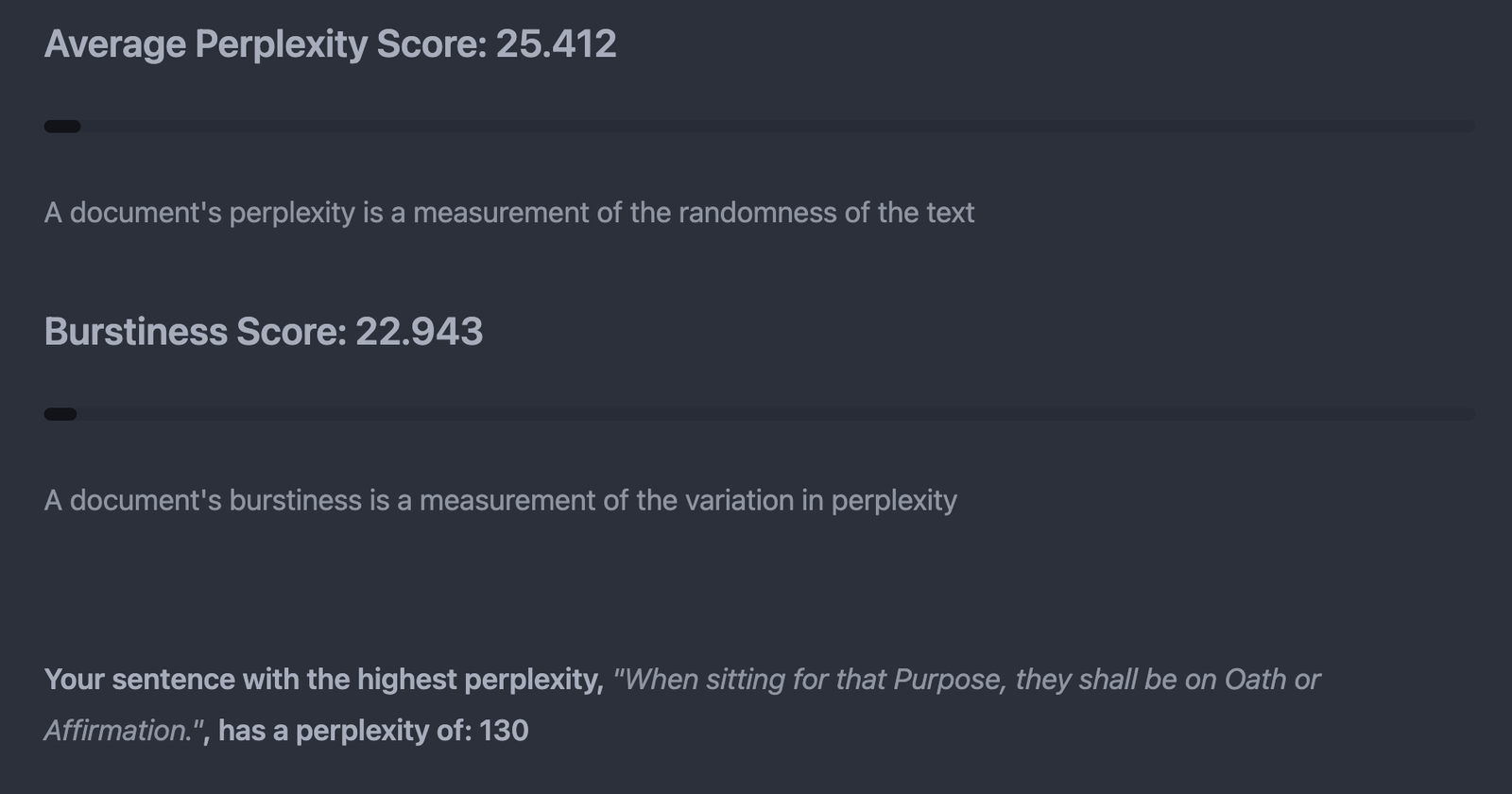

A linguagem histórica e formal, muitas vezes, dá baixos escores de “perplexidade” e “burstiness”, que interpretam como indicadores da escrita de IA.

Escritores humanos podem usar frases comuns e estilos formais, resultando em escores semelhantes.

Este exercício reforçou a ideia da FTC de que os consumidores devem duvidar das pontuações do detector de IA.

Forças e limitações

Os resultados de vários estudos destacam os pontos fortes e limitações das ferramentas de detecção de IA.

Enquanto os detectores de IA mostraram alguma precisão na detecção de texto gerado por IA, eles também exibiram preconceitos, problemas de usabilidade e vulnerabilidades às técnicas de evasão.

Mas os próprios estudos podem ser defeitos, deixando tudo para especulação.

São necessárias mudanças para combater preconceitos, aumentar a eficácia e assegurar uma detecção precisa em várias situações.

Pesquisa e desenvolvimento contínuos são cruciais para promover a confiança nos detectores de IA e criar uma paisagem digital mais equitativa e segura.

Imagem em destaque: Ascannio/Shutterstock