Nos últimos dias, o Google enfrentou um ataque de spam em suas pesquisas que se mostrou extremamente descontrolado. Vários domínios estão aparecendo em posições elevadas para um grande número de palavras-chave, sugerindo que a magnitude desse ataque poderia alcançar milhões de frases-chave.

A descoberta inicial do spam foi feita por Lily Ray e está em dia.

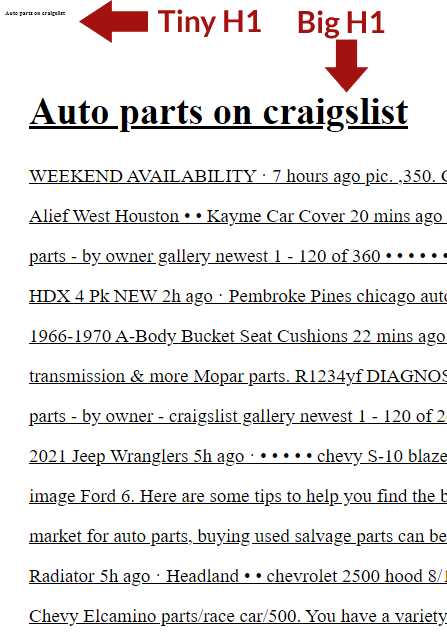

Se você pesquisar atualmente no Google por “peças de automóveis usadas no Craigslist”, todos os resultados no top 20 são spam, exceto os dois primeiros resultados do Craigslist.

— Postagem de Lily Ray em 20 de dezembro de 2023.

De que forma é possível remover os algoritmos do Google.

Os sites de spam estão explorando atualmente três brechas que fazem parte do critério de classificação do Google, as quais não são novas e têm sido exploradas por spammers há bastante tempo, mas não de forma tão intensa como tem ocorrido recentemente.

Uma das principais razões para o sucesso do spam é que os sites de spam estão classificando consultas de pesquisa de baixa concorrência, o que facilita a classificação.

Há duas categorias de pesquisas com pouca demanda em que os sites de spam estão identificando possibilidades.

Paráfrase do texto: A primeira oportunidade é o algoritmo de busca local, que é utilizado quando as pessoas procuram por estabelecimentos próximos, como restaurantes ou horários de filmes. Esse algoritmo é menos restritivo e possibilita que um restaurante local sem links seja classificado.

Paráfrase: As palavras-chave de cauda longa são frases menos comuns e específicas, o que resulta em menor concorrência e facilita a classificação nos mecanismos de busca. Essas frases têm um volume de pesquisa baixo e ocorrem ocasionalmente, seja mensalmente ou anualmente.

Muitos dos sites de spam são recentes, com os domínios sendo registrados apenas 24 a 48 horas antes de serem classificados.

O Google oferece aos novos sites um breve período inicial de vantagem, enquanto seu algoritmo os avalia durante uma fase inicial favorável, na qual o site pode se posicionar em pesquisas.

Muitos dos domínios foram registrados recentemente, nas últimas 2448 horas. Isso pode indicar que esses domínios estão aproveitando uma breve oportunidade para surgir, obter classificação em múltiplas pesquisas e depois desaparecer.

Um funcionário do Google explicou as razões pelas quais novos sites podem obter uma boa classificação nos resultados de pesquisa.

Especialmente ao lidar com sites recém-criados, enfrentamos o desafio de não possuir muitos dados de referência, o que nos leva a realizar estimativas.

Dependendo da forma como realizamos previsões, em alguns casos podemos acabar dando mais destaque a este site no início do que o que os sinais indicam no final.

A inserção de links auxilia o Google na identificação de sites considerados spam.

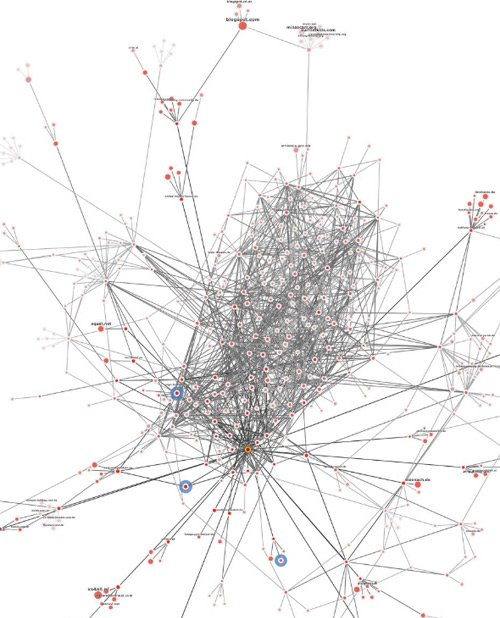

Recentemente, fiquei intrigado com uma série de publicações feitas por Bill Hartzer (perfil do LinkedIn), nas quais ele compartilhou um gráfico de links criado pela ferramenta de backlinks Majestic. Esse gráfico revelou as redes de links de diversos sites de spam.

O gráfico de links compartilhado por ele exibiu pontuações de páginas altamente conectadas entre si, o que é um padrão bastante comum em redes de links consideradas spam.

Captura de tela de uma rede altamente conectada.

Bill e eu discutimos os sites de spam no Facebook Messenger e chegamos à conclusão de que, apesar dos spammers investirem muito esforço na construção de uma rede de backlinks, os links não eram os principais responsáveis pelos altos rankings.

Os links são possivelmente incluídos para auxiliar o Google na descoberta de novos sites de spam, permitindo que sejam rastreados e, eventualmente, classificados.

Bill mencionou.

Em minha visão, parte da responsabilidade recai sobre o Google, que parece estar valorizando mais o conteúdo do que os links.

Estou totalmente de acordo com a ideia de que o Google está priorizando o conteúdo em vez dos links. No entanto, acredito que os links de spam são deixados intencionalmente para que o Googlebot consiga identificar e indexar as páginas de spam, mesmo que seja por um curto período de tempo.

Após serem indexadas, as páginas de spam provavelmente estão se aproveitando de duas vulnerabilidades que identifico nos algoritmos do Google. Vou explicá-las a seguir.

Spam desenfreado nos resultados de pesquisa do Google.

Diversos sites estão sendo classificados com base em frases de cauda longa que são relativamente simples de posicionar, assim como frases com um elemento de busca local, também de fácil classificação.

O termo Longtail surgiu há quase duas décadas e ganhou destaque com o livro de 2006 intitulado A Cauda Longa: Como o futuro dos negócios está na venda de uma grande variedade de produtos em pequenas quantidades.

Os spammers conseguem posicionar-se bem em frases pouco buscadas, já que há menos concorrência, facilitando a classificação.

Assim, caso um spammer crie um grande número de páginas contendo frases de cauda longa, é possível que essas páginas consigam posicionar centenas de milhares de palavras-chave diariamente em um intervalo de tempo reduzido.

Empresas como a Amazon utilizam a estratégia do long tail para comercializar uma grande quantidade de produtos únicos diariamente, em contraste com a venda repetida de um único produto várias vezes ao dia.

Os spammers estão se aproveitando da facilidade de classificação para frases de cauda longa.

Os spammers estão aproveitando a lacuna presente na Pesquisa Local.

O algoritmo utilizado para busca local difere do algoritmo empregado para classificar palavras-chave não locais.

Os casos que foram revelados consistem em diferentes formas de Craigslist e termos de busca similares.

Exemplos incluem frases como peças de automóveis no Craigslist, quartos para alugar no Craigslist, venda por proprietário no Craigslist, e diversas outras palavras-chave, a maioria das quais não menciona o termo Craigslist.

O alcance do spam é vasto e ultrapassa os simples termos de pesquisa que contenham a palavra “Craigslist”.

Como é a aparência da página de Spam.

É impossível visualizar a aparência da página de spam ao visitar as páginas usando um navegador.

Eu busquei acessar o código fonte dos sites bem posicionados no Google, porém os sites de spam direcionam automaticamente para outro domínio.

Posteriormente, inseri o endereço de spam no verificador de links do W3C para acessar o site, porém o bot do W3C também não conseguiu visualizá-lo.

Assim, alterei as configurações do meu navegador para que se identificasse como Googlebot, no entanto, o site de spam continuou a me redirecionar.

Isso sugeria que o site não estava checando se o usuário era o Googlebot.

O site de spam verificava os endereços IP do Googlebot e, se o visitante tivesse um endereço IP correspondente ao do Google, exibia conteúdo específico para o Googlebot.

Todos os visitantes restantes são redirecionados para diferentes domínios que apresentam informações básicas.

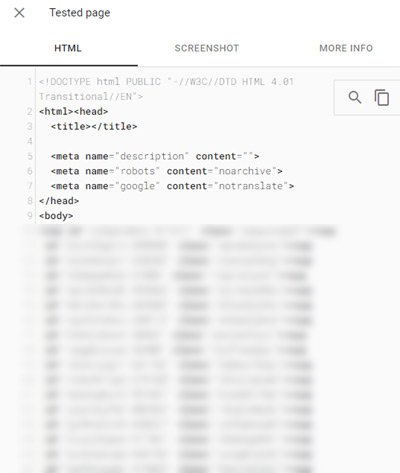

Para visualizar o código HTML do site, precisei acessá-lo por meio de um endereço IP do Google. Em seguida, utilizei a ferramenta de teste de Rich Results do Google para acessar o site de spam e salvar o código HTML da página.

Eu ensinei Bill Hartzer a extrair o código HTML usando o testador Rich Results e ele logo foi compartilhar isso no Twitter, haha. Incrível!

O Rich Results Tester possui uma função que permite exibir o código HTML de uma página da internet. Assim, você pode copiar o código, colá-lo em um documento de texto e depois salvá-lo como um arquivo HTML.

Captura de tela de código HTML fornecido pela Ferramenta de Resultados Ricos.

Depois, modifiquei o documento HTML para excluir todo o código JavaScript e, em seguida, salvei o arquivo mais uma vez.

Agora eu conseguia visualizar como a página web é vista pelo Google.

Imagens indesejadas de e-mails não solicitados.

Classificação de domínio para mais de 300 mil palavras-chave.

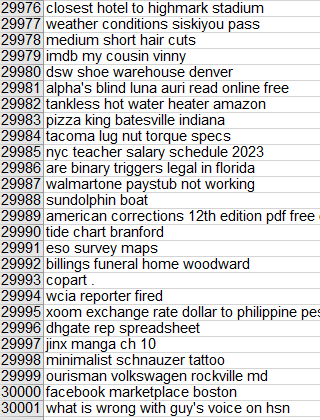

Bill me mandou uma planilha com uma lista de frases-chave de um site de spam que foi classificado para mais de 300.000 palavras-chave.

Imagem exibindo termos-chave associados a um determinado site.

Existiam diversas palavras-chave utilizadas no Craigslist, além de frases mais longas que incluíam um componente de busca local. Como já foi dito, é simples posicionar-se bem para frases mais longas e locais, e combinar ambos os tipos de frases facilita ainda mais o ranqueamento para essas palavras-chave.

Por que o método de envio de emails não solicitados é eficaz?

Como já foi explicado, o algoritmo utilizado na pesquisa local difere do algoritmo utilizado na pesquisa não local. Por exemplo, um site com foco local não necessita de uma grande quantidade de links para ser classificado em uma busca. É suficiente que as páginas contenham palavras-chave específicas para acionar o algoritmo de pesquisa local e, assim, serem classificadas.

O algoritmo utilizado para buscas locais é distinto e mais flexível, permitindo que sites de natureza local tenham oportunidades de ranqueamento. Os algoritmos de busca locais são tão flexíveis que um site composto principalmente de texto em latim poderia ser classificado para uma expressão como “Rinoplastia Plano Texas”.

O Google está ciente do problema de spam há pelo menos desde 19 de dezembro, conforme afirmado em um tweet por Danny Sullivan.

Sim, eu já enviei esse para a equipe de pesquisa. Aqui está uma olhada. E está sob análise.

Tweet da conta oficial do Google SearchLiaison em 19 de dezembro de 2023.

Existem diversas formas pelas quais o Google pode agir, como por exemplo ser mais exigente e não permitir que sites de certos domínios sejam bem classificados. Será interessante observar se o Google conseguirá, após tanto tempo, encontrar uma maneira eficaz de combater esse tipo de spam.

A imagem principal é fornecida por Shutterstock e foi criada por Kateryna Onyshchuk.